Новости

29.06.2020

Книга «Генеративное глубокое обучение. Творческий потенциал нейронных сетей»

Машины можно научить рисовать, писать и сочинять музыку. Вы сами можете посадить искусственный интеллект за парту или мольберт, для этого достаточно познакомиться с самыми актуальными примерами генеративных моделей глубокого обучения: вариационные автокодировщики, генеративно-состязательные сети, модели типа кодер-декодер и многое другое.

Дэвид Фостер делает понятными и доступными архитектуру и методы генеративного моделирования, его советы и подсказки сделают ваши модели более творческими и эффективными в обучении. Вы начнете с основ глубокого обучения на базе Keras, а затем перейдете к самым передовым алгоритмам.

- Разберитесь с тем, как вариационные автокодировщики меняют эмоции на фотографиях.

- Создайте сеть GAN с нуля.

- Освойте работу с генеративными моделями генерации текста.

- Узнайте, как генеративные модели помогают агентам выполнять задачи в рамках обучения с подкреплением.

- Изучите BERT, GPT-2, ProGAN, StyleGAN и многое другое.

Цели и подходы

В этой книге рассматриваются ключевые методы, доминировавшие в ландшафте генеративного моделирования в последние годы и позволившие добиться впечатляющего прогресса в творческих задачах. Кроме знакомства с базовой теорией генеративного моделирования, в этой книге мы будем создавать действующие примеры некоторых ключевых моделей, заимствованных из литературы, и шаг за шагом рассмотрим реализацию каждой из них.

На протяжении всей книги вам будут встречаться короткие поучительные истории, объясняющие механику некоторых моделей. Пожалуй, один из лучших способов изучения новой абстрактной теории — сначала преобразовать ее во что-то менее абстрактное, например в рассказ, и только потом погружаться в техническое описание. Отдельные разделы теории будут более понятны в контексте, включающем людей, действия и эмоции, а не в контексте таких довольно абстрактных понятий, как, допустим, нейронные сети, обратное распространение или функции потерь.

Рассказ и описание модели — это обычный прием объяснения одного и того же с двух точек зрения. Поэтому, изучая какую-то модель, иногда будет полезно вернуться к соответствующему рассказу. Если же вы уже знакомы с конкретным приемом, то просто получайте удовольствие, обнаруживая в рассказах параллели с каждым элементом модели!

В первой части книги представлены ключевые методы построения генеративных моделей, включая обзор глубокого обучения, вариационных автокодировщиков и генеративно-состязательных сетей. Во второй части эти методы применяются для решения нескольких творческих задач (рисование, сочинение рассказов и музыки) с помощью таких моделей, как CycleGAN, моделей типа кодер-декодер и MuseGAN. Мы увидим, как генеративное моделирование можно использовать для оптимизации выигрышной стратегии игры (World Models), рассмотрим самые передовые генеративные архитектуры, доступные сегодня: StyleGAN, BigGAN, BERT, GPT-2 и MuseNet.

Наивная байесовская параметрическая модель

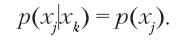

Наивная байесовская параметрическая модель использует простое предположение, чтобы резко уменьшить количество параметров для оценки. Мы наивно предполагаем, что каждый признак xjне зависит от любого другого признака  В отношении набора данных, полученных на Ирме, это означает, например, что выбор цвета волос не влияет на выбор типа одежды, а выбор типа очков не влияет на выбор прически. Более формально, для всех признаков

В отношении набора данных, полученных на Ирме, это означает, например, что выбор цвета волос не влияет на выбор типа одежды, а выбор типа очков не влияет на выбор прически. Более формально, для всех признаков

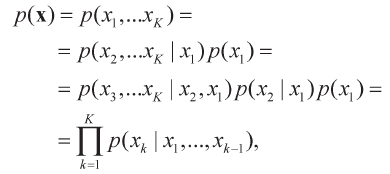

Это известно как наивное байесовское предположение. Чтобы применить его, сначала используется цепное правило вероятности для записи функции плотности в виде произведения условных вероятностей:

где K — общее число признаков (то есть пять в примере с планетой Ирм).

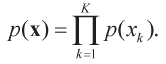

Теперь применим наивное байесовское предположение, чтобы упростить последнюю строку:

Это — наивная байесовская модель. Задача сводится к оценке параметров  для каждого признака в отдельности и их перемножению для определения вероятности любой возможной комбинации.

для каждого признака в отдельности и их перемножению для определения вероятности любой возможной комбинации.

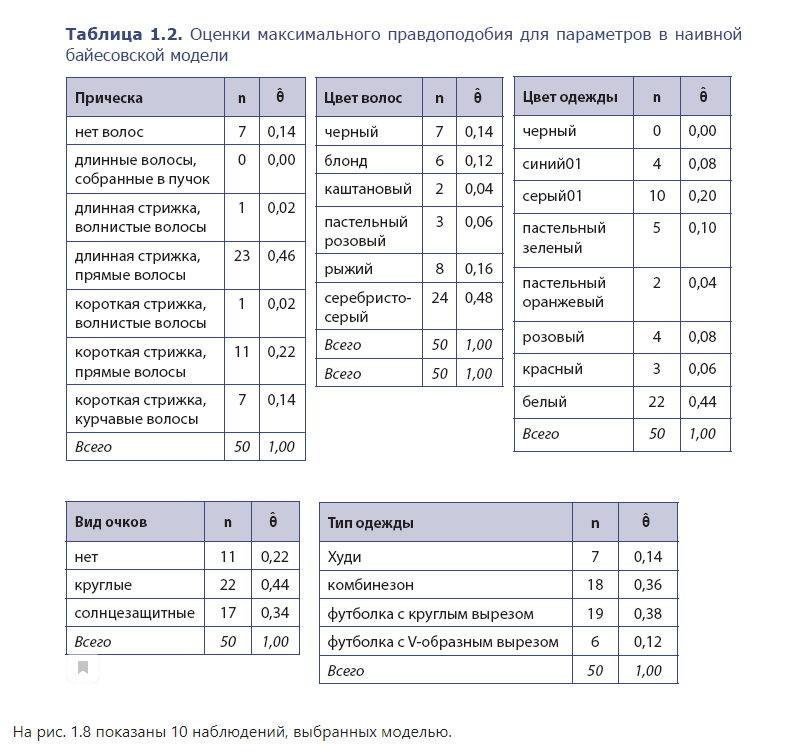

Сколько параметров нужно оценить в нашей задаче? Для каждого признака нужно оценить параметр для каждого значения, которое может принять этот признак. Следовательно, в примере с планетой Ирм эта модель определяется всего 7 + 6 + 3 + 4 + 8 – 5 = 23 параметрами.

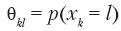

Оценка максимального правдоподобия  вычисляется как

вычисляется как

где  — число раз, когда признак k принимает значение l в наборе данных, а N = 50 — общее число наблюдений.

— число раз, когда признак k принимает значение l в наборе данных, а N = 50 — общее число наблюдений.

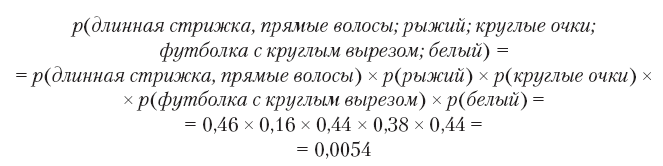

В табл. 1.2 показаны вычисленные параметры для набора данных с планеты Ирм. Чтобы найти вероятность, с которой модель сгенерирует некоторое наблюдение x, достаточно перемножить вероятности отдельных признаков. Например:

Обратите внимание: эта комбинация отсутствует в исходном наборе данных, но наша модель определяет для нее ненулевую вероятность, а значит, вполне может сгенерировать ее. Кроме того, вероятность этой комбинации выше, чем, например, (длинная стрижка, прямые волосы; рыжий; круглые очки; футболка с круглым вырезом; синий01), потому что белый цвет одежды появляется в наборе наблюдений чаще, чем синий.

То есть наивная байесовская модель способна выявить некоторую структуру данных и использовать ее для создания новых образцов, отсутствующих в исходном наборе. Модель оценила вероятность встретить каждое значение признака независимо от других, поэтому при использовании наивного байесовского предположения можно перемножить эти вероятности, чтобы построить полную функцию плотности,

Для этой простой задачи наивное байесовское предположение о независимости признаков является разумным и, следовательно, дает хорошую генеративную модель.

Теперь посмотрим, что получится, если это предположение оказывается ошибочным.

С полным содержанием статьи можно ознакомиться на сайте "Хабрахабр": https://habr.com/ru/company/piter/blog/504956/

Комментарии: 0

Пока нет комментариев